引言:步入AI世界

随着人工智能技术的迅猛发展,机器学习与深度学习已成为驱动创新的核心引擎。TensorFlow,作为Google开源的一款强大且灵活的机器学习框架,为开发者提供了构建和部署AI应用的基石。本系列文章旨在从零开始,引导读者掌握使用TensorFlow进行实战开发的关键步骤。作为开篇,我们将首先夯实基础,深入探讨人工智能的基本概念及其软件开发的核心知识。

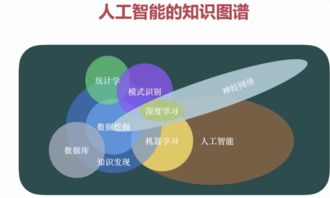

一、人工智能基础知识精要

理解人工智能(AI)是开启TensorFlow之旅的前提。人工智能是一个广泛的领域,致力于创造能够执行通常需要人类智能的任务的机器或软件。其核心分支包括:

- 机器学习:AI的核心实现方式,使计算机能够从数据中学习规律并进行预测,而无需进行明确的编程。它是大多数现代AI应用的基础。

- 深度学习:机器学习的一个子集,它使用被称为“神经网络”的复杂结构模型,尤其擅长处理图像、语音和文本等非结构化数据。TensorFlow正是深度学习领域的旗舰框架之一。

在深度学习中,神经网络模仿人脑神经元的工作方式,通过多层处理(“深度”)来提取数据的多层次特征。理解诸如神经元、权重、偏置、激活函数(如ReLU、Sigmoid)、损失函数和优化器(如梯度下降) 等基本概念至关重要。

二、AI基础软件开发环境搭建

工欲善其事,必先利其器。在开始TensorFlow编程前,需要搭建合适的开发环境。

- 编程语言:Python 是AI开发的事实标准语言,因其简洁的语法、丰富的科学计算库(如NumPy、Pandas)和庞大的AI生态而广受青睐。确保你已安装Python(建议3.7及以上版本)。

- 开发工具:

- Jupyter Notebook / Jupyter Lab:非常适合进行交互式代码编写、数据可视化和教学,是学习和原型设计的绝佳选择。

- PyCharm、VS Code 等集成开发环境(IDE),提供代码补全、调试等高级功能,适合大型项目开发。

- 环境管理:强烈推荐使用 Anaconda 或 venv 创建独立的Python虚拟环境。这可以避免不同项目间的库版本冲突。

三、TensorFlow核心概念与安装

TensorFlow使用“张量”(Tensor)作为基本数据结构。张量可以简单理解为多维数组(标量是0维张量,向量是1维,矩阵是2维)。数据在操作之间以张量的形式流动(Flow),故名TensorFlow。

安装TensorFlow 非常简单。在配置好的Python环境中,通常只需一条pip命令:`bash

pip install tensorflow`

对于需要GPU加速的用户(可大幅提升模型训练速度),请确保系统已安装CUDA和cuDNN,然后安装tensorflow-gpu(在TF 2.x之后,通常统一为tensorflow包,会自动检测GPU)。

安装后,在Python中通过 import tensorflow as tf 即可导入并使用。

四、第一个TensorFlow程序:从线性回归开始

让我们通过一个经典的机器学习问题——线性回归,来直观感受TensorFlow的工作流程。线性回归的目标是找到一条最佳拟合直线,描述输入特征 X 和输出目标 y 之间的线性关系。

`python

import tensorflow as tf

import numpy as np

import matplotlib.pyplot as plt

1. 准备数据

生成模拟数据:y = 2*x + 1 + 噪声

X = np.linspace(-1, 1, 100)

y = 2 * X + 1 + np.random.normal(0, 0.1, 100)

2. 构建模型

定义可训练参数(权重和偏置),初始值为随机数

W = tf.Variable(tf.random.normal([1]))

b = tf.Variable(tf.zeros([1]))

3. 定义模型(前向传播)

def linear_model(x):

return W * x + b

4. 定义损失函数(均方误差)

def lossfn(ytrue, ypred):

return tf.reducemean(tf.square(ytrue - ypred))

5. 选择优化器(随机梯度下降)

optimizer = tf.optimizers.SGD(learning_rate=0.1)

6. 训练模型

epochs = 100 # 训练轮数

for epoch in range(epochs):

with tf.GradientTape() as tape: # 梯度带,记录计算过程以自动求导

ypred = linearmodel(X)

loss = lossfn(y, ypred)

# 计算梯度

gradients = tape.gradient(loss, [W, b])

# 根据梯度更新参数

optimizer.apply_gradients(zip(gradients, [W, b]))

if (epoch+1) % 20 == 0:

print(f'Epoch {epoch+1}, Loss: {loss.numpy():.4f}, W: {W.numpy()[0]:.4f}, b: {b.numpy()[0]:.4f}')

7. 结果可视化

plt.scatter(X, y, label='Original Data')

plt.plot(X, linear_model(X), color='red', label='Fitted Line')

plt.legend()

plt.show()`

代码解析:

- 我们创建了变量 W 和 b,它们是模型要学习的参数。

- 使用 tf.GradientTape() 上下文管理器来自动计算损失函数关于参数的梯度。

- 优化器根据计算出的梯度更新参数,不断降低损失值。

- W 和 b 的值应接近真实的 2 和 1。

五、与展望

本章我们梳理了人工智能与机器学习的核心概念,搭建了基础的TensorFlow开发环境,并通过一个简单的线性回归实例,实践了TensorFlow模型构建、训练和评估的基本流程。关键在于理解定义模型、计算损失、计算梯度、更新参数这一循环迭代的训练本质。

这仅仅是起点。在接下来的篇章中,我们将深入TensorFlow的高层API(如Keras),构建更复杂的神经网络(如全连接网络、卷积神经网络CNN、循环神经网络RNN),处理真实世界的数据集,并探讨模型部署等进阶主题。扎实的基础是应对未来复杂挑战的保障,请务必理解并亲手运行本章的每一行代码。

让我们在TensorFlow的海洋中,继续扬帆起航。